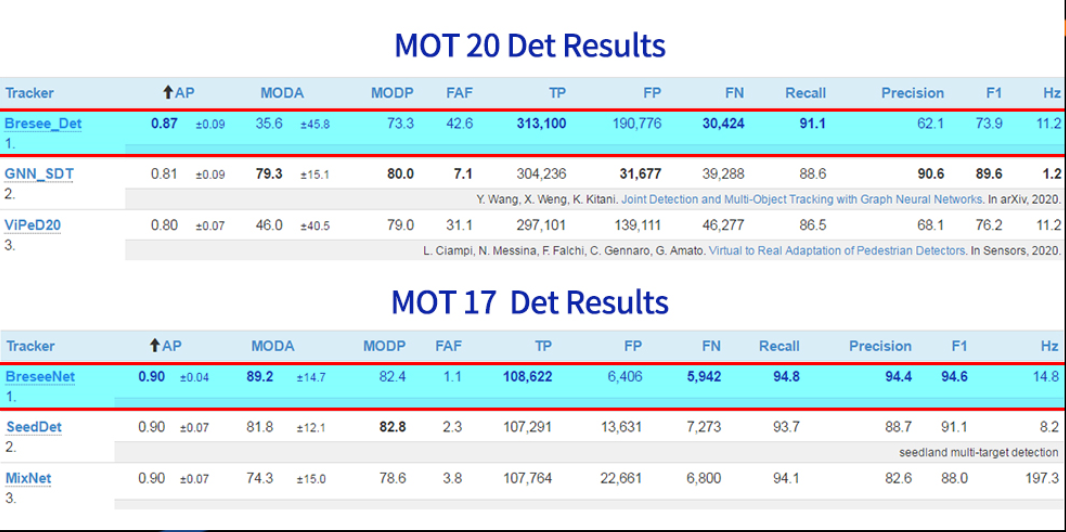

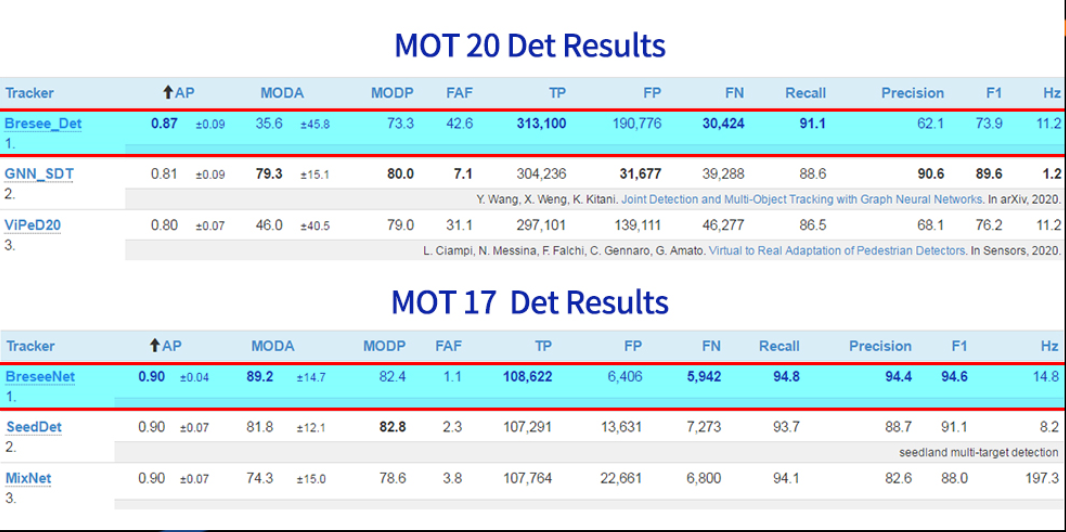

12月28日,博观智能(Bresee)在国际最权威的多目标跟踪挑战赛MOT(Multiple Object Tracking) Challenge上,斩获MOT17Det和MOT20Det多目标检测任务双第一。两榜成绩均以明显优势超过腾*、*汤、海***等知名AI公司和斯坦福大学、卡内基梅隆大学等顶尖的学术研究机构,同时创造了两项新的世界纪录。

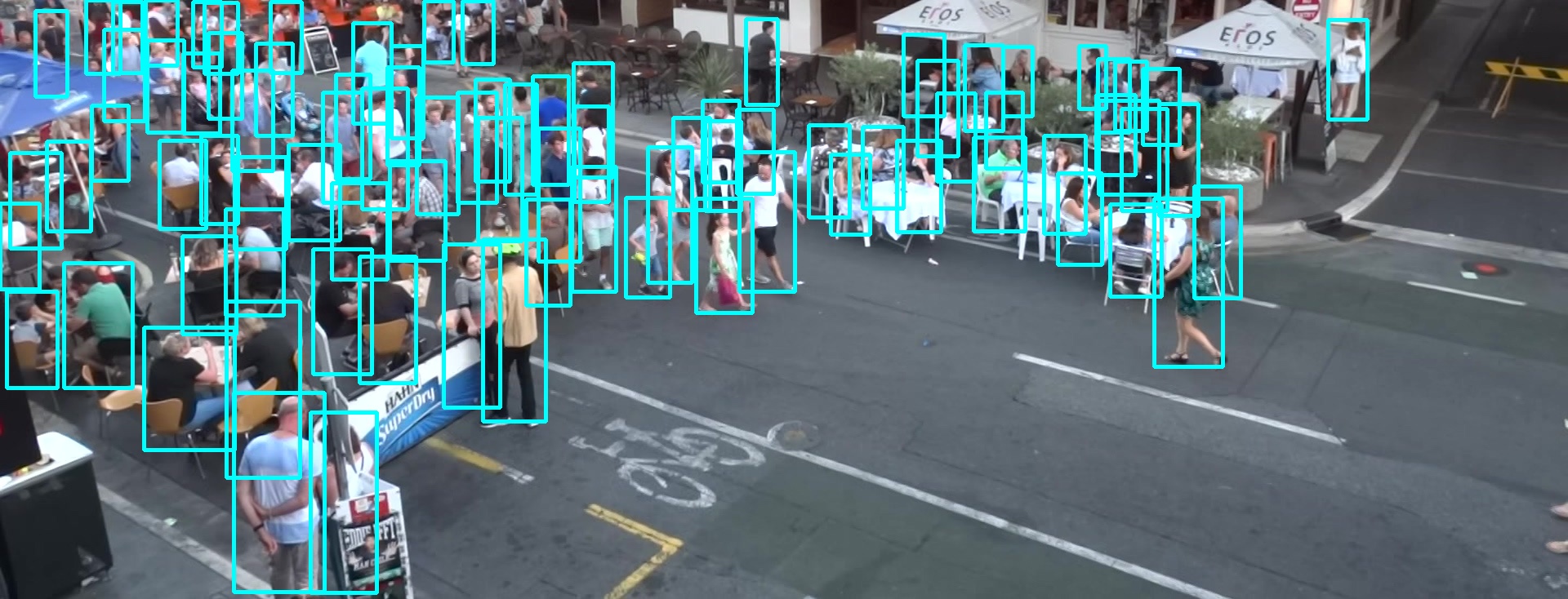

作为计算机视觉领域最广泛、最热门的技术应用之一,“多目标跟踪”是指对视频图像中的多个感兴趣目标轨迹进行跟踪并提取,并通过时域关联,得到其运动轨迹信息的AI技术。多目标跟踪在视频目标分析、场景剖析、行为事件理解、交通管理及安全防控等应用中,都是必须解决的关键课题。目标跟踪技术要重点解决遮挡、形变、光线变化、随机运动、运动过快等难题。同时在解析过程中,需要利用目标跟踪技术降低耗时、提升精度以及减少重复分析。

作为计算机视觉领域最广泛、最热门的技术应用之一,“多目标跟踪”是指对视频图像中的多个感兴趣目标轨迹进行跟踪并提取,并通过时域关联,得到其运动轨迹信息的AI技术。多目标跟踪在视频目标分析、场景剖析、行为事件理解、交通管理及安全防控等应用中,都是必须解决的关键课题。目标跟踪技术要重点解决遮挡、形变、光线变化、随机运动、运动过快等难题。同时在解析过程中,需要利用目标跟踪技术降低耗时、提升精度以及减少重复分析。

Multiple Object Tracking (MOT) Challenge是目前国际多目标跟踪领域最权威的测试平台,由苏黎世联邦理工学院、阿德莱德大学以及达姆施塔特工业大学等全球多所顶尖大学联合举办。MOT20Det、MOT17Det主要针对多行人的目标检测,其中MOT17Det训练集包含6段视频,标注数据总共为11.2万个,在测试集的6段视频中,待检测目标为18.8万个,因此检测难度极高,是众多AI研究机构与企业争相挑战的业界标杆,吸引了众多一流AI行业公司和学术机构持续参与评测。

如何破解“人从众”检测难题

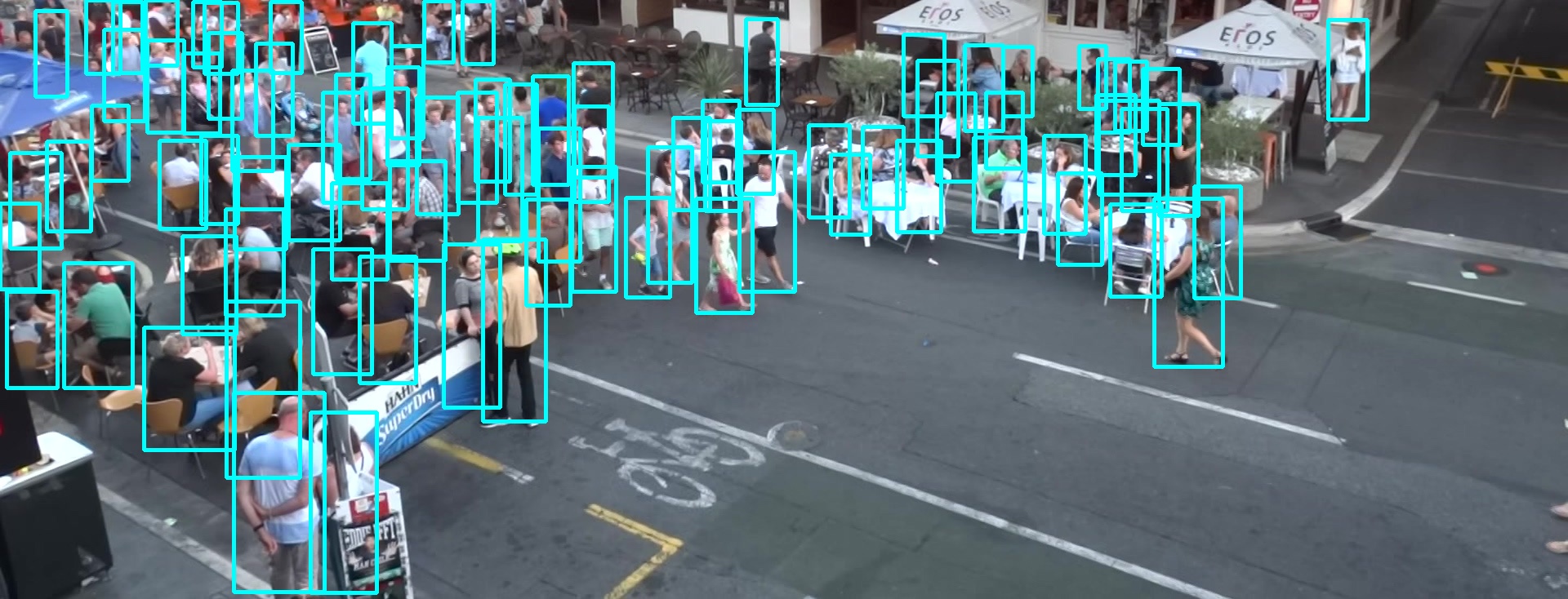

行人检测任务通常接收一张大图,通过神经网络模型提取图像特征,并进行坐标回归,最终得到全部待检测行人的检测框位置。而在MOT数据集中,在如此复杂的场景下,拍摄场景多样、行人间相互遮挡、人体尺寸多样化、图像模糊、拍摄视角动态变化、环境光线变化复杂,给检测算法提出了很高的要求。博观智能基于自研AdaptNet深度网络结构的不断升级迭代,在多目标行人检测算法的多领域取得了突破:

1.自适应加权损失函数:

MOT榜单的难度之一就是人群密集遮挡情况下,检测框的回归准确度低。因此,博观算法团队提出了自适应加权损失函数,在训练时当模型的分类准确度较高时,重点关注模型的回归损失。同时,增加行人检测框是否完整的判罚因子,进一步提升了密集遮挡情况下,行人检测框的完整性。

2.多尺度训练:

由于MOT数据集人体密集,在训练时,算法团队采用多尺度的训练方式,将一幅图拆分为若干子图送入网络进行训练,捕获更多的空间和语义信息,有效提升了模型的收敛速度与检测的准确度。

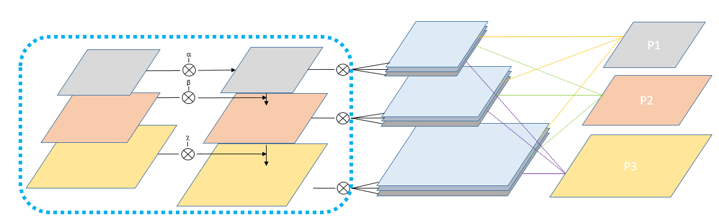

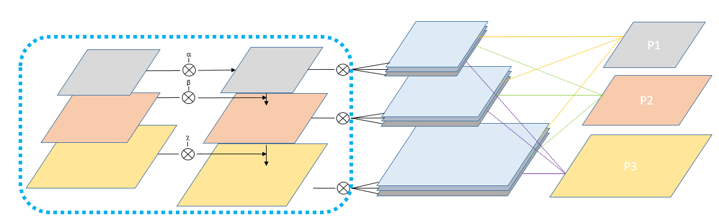

3.融合Attention的FPN模块:

在网络的多尺度特征图融合时,采用自适应特征加权替换了原来直接将特征图合并的方式,不仅使得浅层的位置信息更快传递到大目标的检测特征图上,而且避免了不同分辨率特征图互相干扰的情况,提高了大尺寸人体的定位精度。对于不同比例的人体,每一个卷积扩张为1:1、1:4、2:1三种尺度,使之更容易学习到不同比例的人体信息。

博观智能自研AdaptNet深度网络框架,近年来多次斩获项世界冠军:

博观智能自研AdaptNet深度网络框架,近年来多次斩获项世界冠军:

2020.12:Multiple Object tracking Challenge国际交通场景多目标检测挑战赛,MOT20和MOT17测试集双冠军。

2020.9:世界最大的车辆ReID公开数据集 VERI-Wild冠军。

2019.11:三大主流ReID数据集 Market1501、DukeMTMC-reID、CUHK03上刷新世界纪录。

2019.3:Multiple Object trackingChallenge国际交通场景多目标检测挑战赛,MOT17测试集冠军。

2017.2:自动驾驶最重要测试集——KITTI挑战赛,车道检测冠军。